LOKALE Installation von LLAMA KI unter LINUX MINT Teil1 - Erfahrungsbericht, Erste Schritte

Hallo zusammen,

nach ein paar harten Tagen Try & Error habe ich nun ein Opensource Derivat der LLama KI lokal auf Linux Mint zum Laufen gebracht.

An und für sich sollte dieses gar keine Meldung wert sein wenn alle so getan hätte wie man es sich vorstellt.

Im Prinzip muss man nur die richtigen Quellen Suchen,

- Downloaden,

- die Software Kompilieren

- ein bereits angelerntes Modell herunterladen

- dann die Software mit dem Modell und den richtigen Parametern starten.

FERTIG.

ABER, die Tücken liegen im Detail.

Der Download der Software Komponenten von Github brach zigmal an der gleichen Stelle ab.

Ofenbar war eine Datei zum Bearbeiten ausgeloggt......

Als ich die am 2. Tag dann endlich hatte ging das Kompilieren nicht.

Der Kompiler brauchte noch etliche Nachinstallationen und Bibliotheken.

Ausserdem mal zusätzlich CUDA Bibliotheken installiert zur GPU Unterstützung der KI Berechnung.

Schritt für Schritt habe cih mich in den Fehlermeldungen weiter gearbeitet und die fehlenden Dateien im Internet gesucht und geladen.

Wieder war ein ganzer Tag weg.

Dann gestern Abend das AHA Erlebnis: Die Software startet.

Aber nur um zu melden das sie das Sparchmodell nicht laden kann.

Dabei war das exakt das beschriebene Original.

Egal, ich wollte die KI eh deutsch sprechen lassen, also los auf Suche.

Über 4000 Treffer- wow was die Leute so alles treiben.

Auf deutsch reduziert blieben noch 5 Modelle übrig.

Davon habe ich eine mittleres Gewählt das angeblich gute Ausgabe Ergebnisse liefern soll.

Klar wären die Großen sicher auch in der Qualität besser, aber ich wollte es ja auf einem lokalen Bestandsrechner endlicher Geschwindigkeit testen.

Und heute Überraschung: LLama startet.

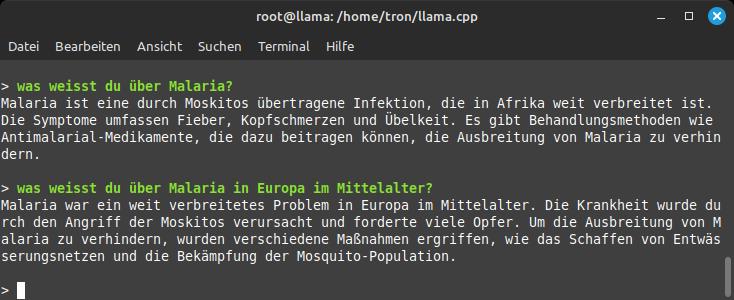

Ich mache die ersten Tests.

dafür nutze ich gerne die gleichen Fragen mit denen ich Online Cloud KIs schon beschäftigt habe.

Und WOW - Die Qualität der Antwort ist gut:

Oha die KI ist jetzt schon Intelligenter als manche Leute, die wieder Sümpfe anlegen wollen.

Aber nun zum technischen Part:

Das Testsystem:

Intel 6Core Xeon X5650 je 2.66Ghz mit HT

24GB RAM DDR3 (3 Module Bandbreitenadditiv)

SATA SSD mit 600MB/Sec lesen/schreiben

NVidia Quadro M6000 Grafikkarte mit CUDA Treiber (3072 Cuda Kerne, 12GB Grafikram)

Betriebssystem:

Kernel: 6.5.0-14-generic x86_64 bits: 64 compiler: N/A Desktop: Cinnamon 5.8.4 tk: GTK 3.24.33 ... Linux Mint 21.2 Victoria base: Ubuntu 22.04 jammy

Dieses System entspricht Leistungstechnisch einem veralteten Gaming System, wie ihr vielleich noch herumstehen habt.

Es hat keine KI Hardware Unterstützung.

Wie wir aber gleich an den Ergebnissen sehen, könnte man dieses System mit einer KI Zusatzkarte und einer breit angebundenen M2Steckkarte durchaus so pushen das es nutzbar würde.

Die Verarbeitungs und Ausgabe Geschwindigkeit:

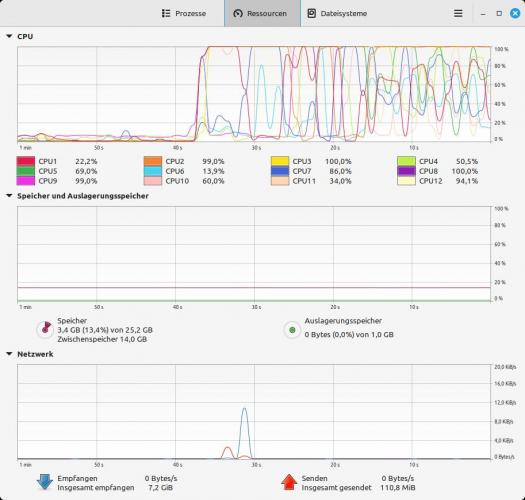

Nach Eingabe einer Anfrage sehe ich einen Netzwerkzugriff, und danach einige Sekunden Rechenzeit unter CPU Vollast.

Leider habe ich keine Anziege über die GPU Last. Aber deren Temperatur steigt im NVidia Setings Tool nicht an. Eventuell wird sie noch nicht richtig verwendet.

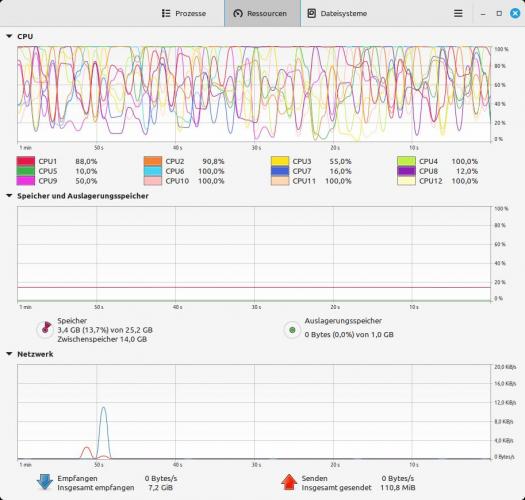

Sobald LLama anfängt die Ausgabe zu beginnen- es geht Buchstabe für Buchstabe wie beim alten Fernschreiber, so ändert sich das Lastverhalten:

Was mich verwundert ist die doch noch recht hohe Last während der langsamen Ausgabe. Eigentlich erwarte ich das mit Beginn der Ausgabe bereits alle Berechnungen abgeschlossen wären, und die CPU Last gegen null tendiert. Es bleibt zu klären ob eventuell eine Sprachausgabe mit berechnet wird, was das Buchstabenweise Vorgehen unter hoher Last erklären könnte.

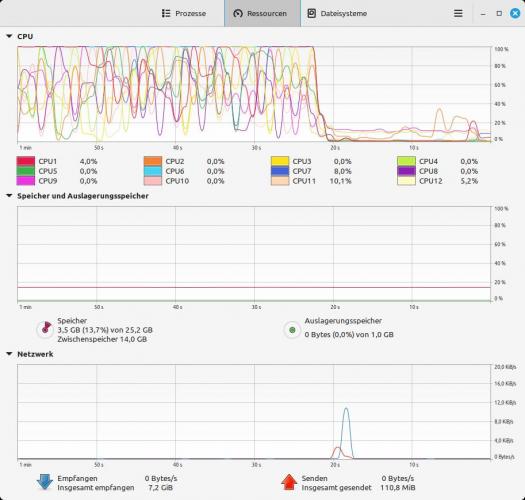

Und schliesslich nach Ende der Ausgabe beruhigt sich die CPU Belastung wieder: Die steil abfallende Flanke markiert das Ende der Textausgabe der Antwort.

Dies ist nur ein erster Vorbericht.

Daher noch keinerlei Anleitungen zum nachbauen.

Im Prinzip entspricht dieser Aufbau aber dem auf folgender Webseite, wo ihr das online berechnet in er Cloud austesten könnt:

https://www.llama2.ai

Warum dann lokal installieren? Nun man kann das Modell lokal für seine Bedürfnisse besser trainieren. Ausserdem ist es unzensiert.

Zudem bleiben eure Eingaben vertraulich, was besonders bei Industrie Spionage ein Thema ist.

Und aktuell geht es ums Lernen und Verstehen.

Bei dem gehosteten Modell habe ich festgestellt das es sehr wohl lernfähig war, aber am nächsten Tag alles Gelernte weg.

Und passt auf- jede KI lügt besser als Käpten Blaubär. Wenn es darum geht wahre Infos zu weiterzuverwenden, müsst ihr die KI dazu bringen euch die Quellen auszugeben, und diese extern nachprüfen! Ich hatte erst heute einen Fall (in der Cloud KI) das sie mir wohl Gefälligkeitsantworten gab. Auf die Frage nach den Quellen spuckte sie Buchtitel und Autoren aus. Die Autoren gab es, aber die hatten offenbar nie die Bücher veröffentlicht von denen die KI berichtete.

Ich werde als Nächstes die Installation auf eine aktuelle leistungsfähige Hardware portieren

(Lenovo P620, 16Core AMD Threadripper Pro, 128GBRAM-8Kanal, M2SSD RAID PXIEx4, NV RTX3080 oder NV RTX6000 oder AMD Radeon RX6800XT)

um zu sehen was das leistungstechnisch ausmacht.

Wenn der Hardwareeinfluss geklärt, und das Testsystem optimiert ist, gehts an Softwartests.

So spare ich dann sinnlose Wartezeiten.

Wir lesen uns- falls es euch interessiert.

Viele Grüße Tron

Hallo zusammen,

nach ein paar harten Tagen Try & Error habe ich nun ein Opensource Derivat der LLama KI lokal auf Linux Mint zum Laufen gebracht.

An und für sich sollte dieses gar keine Meldung wert sein wenn alle so getan hätte wie man es sich vorstellt.

Im Prinzip muss man nur die richtigen Quellen Suchen,

- Downloaden,

- die Software Kompilieren

- ein bereits angelerntes Modell herunterladen

- dann die Software mit dem Modell und den richtigen Parametern starten.

FERTIG.

ABER, die Tücken liegen im Detail.

Der Download der Software Komponenten von Github brach zigmal an der gleichen Stelle ab.

Ofenbar war eine Datei zum Bearbeiten ausgeloggt......

Als ich die am 2. Tag dann endlich hatte ging das Kompilieren nicht.

Der Kompiler brauchte noch etliche Nachinstallationen und Bibliotheken.

Ausserdem mal zusätzlich CUDA Bibliotheken installiert zur GPU Unterstützung der KI Berechnung.

Schritt für Schritt habe cih mich in den Fehlermeldungen weiter gearbeitet und die fehlenden Dateien im Internet gesucht und geladen.

Wieder war ein ganzer Tag weg.

Dann gestern Abend das AHA Erlebnis: Die Software startet.

Aber nur um zu melden das sie das Sparchmodell nicht laden kann.

Dabei war das exakt das beschriebene Original.

Egal, ich wollte die KI eh deutsch sprechen lassen, also los auf Suche.

Über 4000 Treffer- wow was die Leute so alles treiben.

Auf deutsch reduziert blieben noch 5 Modelle übrig.

Davon habe ich eine mittleres Gewählt das angeblich gute Ausgabe Ergebnisse liefern soll.

Klar wären die Großen sicher auch in der Qualität besser, aber ich wollte es ja auf einem lokalen Bestandsrechner endlicher Geschwindigkeit testen.

Und heute Überraschung: LLama startet.

Ich mache die ersten Tests.

dafür nutze ich gerne die gleichen Fragen mit denen ich Online Cloud KIs schon beschäftigt habe.

Und WOW - Die Qualität der Antwort ist gut:

Oha die KI ist jetzt schon Intelligenter als manche Leute, die wieder Sümpfe anlegen wollen.

Aber nun zum technischen Part:

Das Testsystem:

Intel 6Core Xeon X5650 je 2.66Ghz mit HT

24GB RAM DDR3 (3 Module Bandbreitenadditiv)

SATA SSD mit 600MB/Sec lesen/schreiben

NVidia Quadro M6000 Grafikkarte mit CUDA Treiber (3072 Cuda Kerne, 12GB Grafikram)

Betriebssystem:

Kernel: 6.5.0-14-generic x86_64 bits: 64 compiler: N/A Desktop: Cinnamon 5.8.4 tk: GTK 3.24.33 ... Linux Mint 21.2 Victoria base: Ubuntu 22.04 jammy

Dieses System entspricht Leistungstechnisch einem veralteten Gaming System, wie ihr vielleich noch herumstehen habt.

Es hat keine KI Hardware Unterstützung.

Wie wir aber gleich an den Ergebnissen sehen, könnte man dieses System mit einer KI Zusatzkarte und einer breit angebundenen M2Steckkarte durchaus so pushen das es nutzbar würde.

Die Verarbeitungs und Ausgabe Geschwindigkeit:

Nach Eingabe einer Anfrage sehe ich einen Netzwerkzugriff, und danach einige Sekunden Rechenzeit unter CPU Vollast.

Leider habe ich keine Anziege über die GPU Last. Aber deren Temperatur steigt im NVidia Setings Tool nicht an. Eventuell wird sie noch nicht richtig verwendet.

Sobald LLama anfängt die Ausgabe zu beginnen- es geht Buchstabe für Buchstabe wie beim alten Fernschreiber, so ändert sich das Lastverhalten:

Was mich verwundert ist die doch noch recht hohe Last während der langsamen Ausgabe. Eigentlich erwarte ich das mit Beginn der Ausgabe bereits alle Berechnungen abgeschlossen wären, und die CPU Last gegen null tendiert. Es bleibt zu klären ob eventuell eine Sprachausgabe mit berechnet wird, was das Buchstabenweise Vorgehen unter hoher Last erklären könnte.

Und schliesslich nach Ende der Ausgabe beruhigt sich die CPU Belastung wieder: Die steil abfallende Flanke markiert das Ende der Textausgabe der Antwort.

Dies ist nur ein erster Vorbericht.

Daher noch keinerlei Anleitungen zum nachbauen.

Im Prinzip entspricht dieser Aufbau aber dem auf folgender Webseite, wo ihr das online berechnet in er Cloud austesten könnt:

https://www.llama2.ai

Warum dann lokal installieren? Nun man kann das Modell lokal für seine Bedürfnisse besser trainieren. Ausserdem ist es unzensiert.

Zudem bleiben eure Eingaben vertraulich, was besonders bei Industrie Spionage ein Thema ist.

Und aktuell geht es ums Lernen und Verstehen.

Bei dem gehosteten Modell habe ich festgestellt das es sehr wohl lernfähig war, aber am nächsten Tag alles Gelernte weg.

Und passt auf- jede KI lügt besser als Käpten Blaubär. Wenn es darum geht wahre Infos zu weiterzuverwenden, müsst ihr die KI dazu bringen euch die Quellen auszugeben, und diese extern nachprüfen! Ich hatte erst heute einen Fall (in der Cloud KI) das sie mir wohl Gefälligkeitsantworten gab. Auf die Frage nach den Quellen spuckte sie Buchtitel und Autoren aus. Die Autoren gab es, aber die hatten offenbar nie die Bücher veröffentlicht von denen die KI berichtete.

Ich werde als Nächstes die Installation auf eine aktuelle leistungsfähige Hardware portieren

(Lenovo P620, 16Core AMD Threadripper Pro, 128GBRAM-8Kanal, M2SSD RAID PXIEx4, NV RTX3080 oder NV RTX6000 oder AMD Radeon RX6800XT)

um zu sehen was das leistungstechnisch ausmacht.

Wenn der Hardwareeinfluss geklärt, und das Testsystem optimiert ist, gehts an Softwartests.

So spare ich dann sinnlose Wartezeiten.

Wir lesen uns- falls es euch interessiert.

Viele Grüße Tron